在互联网时代,数据采集是实现各种应用的基础。Opensea作为加密货币艺术品市场的领先平台,拥有大量宝贵的交易数据。然而,面对Opensea数据采集的庞大规模和复杂反爬虫机制,传统的数据采集方法往往效率低下、稳定性差,无法满足实际需求。为此,本文将从多个方面探讨优化Opensea数据采集的技巧,帮助用户实现高效、稳定的数据采集。

请求优化

在Opensea数据采集中,大量的请求往往是一个耗时和资源消耗较大的环节。为了优化请求过程,可以使用请求头优化、合理的请求频率等技巧。通过设置合适的User-Agent、Referer和Cookie等请求头,可以降低请求被阻止的风险,提高数据采集的成功率。此外,合理控制请求频率,避免过快的请求造成服务器的压力过大,从而提高数据采集的效率。

并发处理

并发处理是提高数据采集效率的重要手段。在Python中,可以使用多线程或者异步IO技术来实现并发处理。通过并发处理,可以同时发起多个请求,充分利用系统资源,加快数据采集的速度。在Opensea数据采集中,由于请求是相互独立的,因此并发处理可以充分发挥优势,提高数据采集的效率。

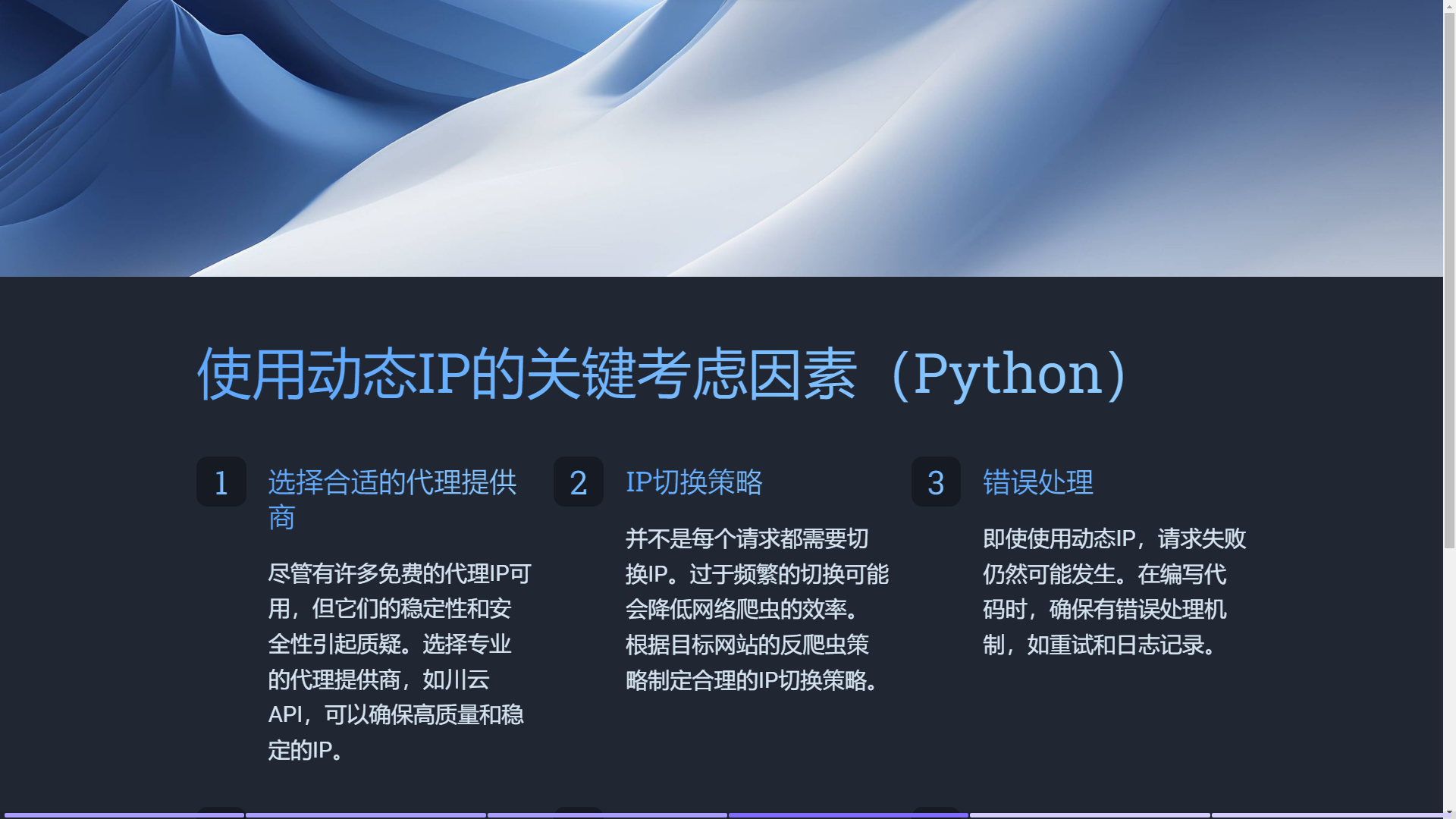

动态代理

Opensea对于频繁请求的IP往往采取封锁措施,影响数据采集的稳定性。为了规避IP封锁,可以使用动态代理。动态代理服务会定期更换IP地址,确保每次请求使用不同的IP,避免被Opensea封锁。通过动态代理,可以保障数据采集的稳定性,提高数据采集的成功率。

反反爬虫

Opensea作为一个重要的交易平台,对数据采集往往设置了严格的反爬虫机制。为了绕过这些机制,可以使用反反爬虫技术。动态解析和伪装请求头、验证码识别、JavaScript渲染等技术都可以用于绕过反爬虫机制。使用这些技术,可以让数据采集更加顺利,保证数据的完整性和准确性。

综上所述,优化Opensea数据采集的技巧包括请求优化、并发处理、动态代理和反反爬虫等方面。这些技巧能够提高数据采集的效率和稳定性,确保数据采集的顺利进行。然而,这些优化技巧在实际应用中可能存在一定的技术门槛和复杂性。为了更轻松地实现Opensea数据采集的优化,推荐使用穿云API作为强大的解决方案。

穿云API为Opensea数据采集提供了全面的功能和强大的支持。首先,穿云API提供高质量的代理IP池,确保IP的稳定性和高匿名性。通过使用穿云API的代理IP,可以有效避免被Opensea封锁的问题,保证数据采集的顺利进行。其次,穿云API提供了丰富的User-Agent池,开发者可以轻松获取常见的浏览器标识,避免被检测为爬虫。通过设置随机的User-Agent,可以增加反爬虫识别的难度,提高数据采集的成功率。此外,穿云API还提供了验证码识别和JavaScript渲染引擎等功能,帮助绕过Opensea的反爬虫机制,确保数据的完整性和准确性。

使用穿云API,您可以轻松地绕过Cloudflare反爬虫的机器人验证,即使您需要发送10万个请求,也不必担心被识别为抓取者。

一个穿云API即可突破所有反Anti-bot机器人检查,轻松绕过Cloudflare验证、CAPTCHA验证,WAF,CC防护,并提供了HTTPAPI和Proxy,包括接口地址、请求参数、返回处理;以及设置Referer,浏览器UA和headless状态等各浏览器指纹设备特征。