Python爬虫工程师在实施网络爬虫时会遇到各种障碍,其中最普遍的就是IP被目标网站封禁的问题。本文将详细探讨如何构建和优化Python爬虫IP代理池,以避免IP封禁问题,并实现更加高效、稳定和可扩展的网络爬虫。

1. 深入理解IP代理池的概念与作用

IP代理池是一个用于存储、管理和维护代理IP地址的系统。通过使用代理IP地址,可以隐藏爬虫的真实IP,从而避免因爬取频率过高导致的IP封禁。

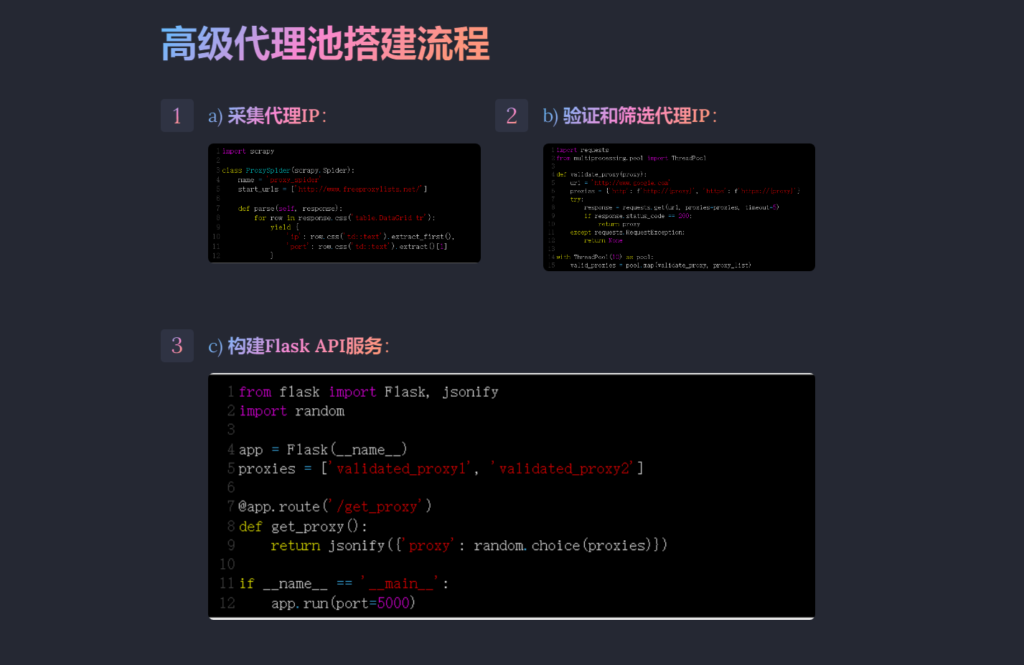

2. 高级代理池搭建流程

a) 采集代理IP:

1 2 3 4 5 6 7 8 9 10 11 12 |

import scrapy class ProxySpider(scrapy.Spider): name = 'proxy_spider' start_urls = ['http://www.freeproxylists.net/'] def parse(self, response): for row in response.css('table.DataGrid tr'): yield { 'ip': row.css('td::text').extract_first(), 'port': row.css('td::text').extract()[1] } |

b) 验证和筛选代理IP:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 |

import requests from multiprocessing.pool import ThreadPool def validate_proxy(proxy): url = 'http://www.google.com' proxies = {'http': f'http://{proxy}', 'https': f'https://{proxy}'} try: response = requests.get(url, proxies=proxies, timeout=5) if response.status_code == 200: return proxy except requests.RequestException: return None with ThreadPool(10) as pool: valid_proxies = pool.map(validate_proxy, proxy_list) |

c) 构建Flask API服务:

1 2 3 4 5 6 7 8 9 10 11 12 |

from flask import Flask, jsonify import random app = Flask(__name__) proxies = ['validated_proxy1', 'validated_proxy2'] @app.route('/get_proxy') def get_proxy(): return jsonify({'proxy': random.choice(proxies)}) if __name__ == '__main__': app.run(port=5000) |

3. 实现Scrapy代理中间件:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 |

from scrapy import signals from urllib.parse import urlparse class ProxyMiddleware: def __init__(self, proxy_url): self.proxy_url = proxy_url @classmethod def from_crawler(cls, crawler): return cls(proxy_url=crawler.settings.get('PROXY_URL')) def process_request(self, request, spider): parsed_url = urlparse(self.proxy_url) request.meta['proxy'] = parsed_url.scheme + '://' + parsed_url.netloc |

4. 优化策略与实践

a) 定时更新和验证:定期更新代理IP列表,并验证其可用性和匿名性,保持代理池的活性和可靠性。

b) 分级与分值:对代理IP进行评级和评分,根据稳定性和响应速度将其分配给不同的爬虫任务。

c) 并发和异步验证:使用异步IO或多线程技术并发验证代理IP,以提高验证效率和准确性。

d) 透明代理避免:避免使用透明代理,以确保爬虫的真实IP地址不会被目标网站识别。

e) 错误处理与自动切换:在爬虫中实现异常处理机制,当遇到网络错误时自动切换代理IP。

f) 动态用户代理:结合使用动态用户代理技术,进一步减少被封禁的风险。

g) 代理速度和稳定性考量:优先选择响应速度快且稳定性好的代理,以保持爬虫的高效运行。

h) 黑名单管理:实现黑名单管理机制,自动剔除被封禁或无法连接的代理IP。

i) 限制请求频率:适当限制爬虫的请求频率,结合代理池使用,降低被封禁的风险。

j) 多源代理池构建:整合多个代理提供商的资源,构建具有多元性和灵活性的代理池。

5结论

通过深入理解IP代理池的概念、流程、优化策略和实践,Python爬虫工程师可以构建出更加强大、稳定和可扩展的网络爬虫。实现优质的IP代理池是避免IP封禁和提高爬虫效率的关键,也是爬虫工程师不可或缺的实用技能。