爬虫在互联网数据收集和分析中起着重要作用,然而,随着网站的反爬虫技术的不断升级,爬虫的隐匿性变得尤为重要。本文将从爬虫和浏览器特征信息两个方面,探讨优化爬虫隐匿性的方法。

爬虫特征信息的修改

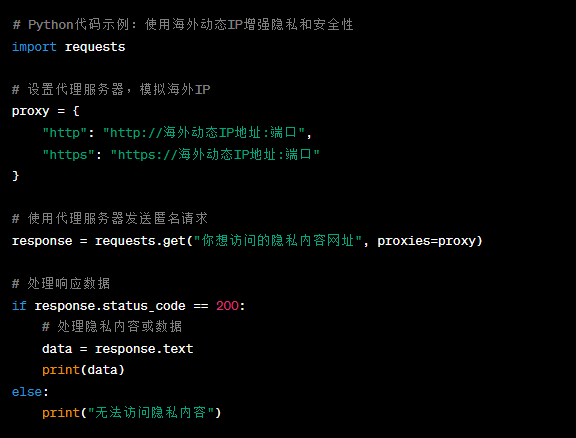

爬虫的特征信息主要包括User-Agent、IP地址和请求频率等。首先,User-Agent是用于标识浏览器身份的HTTP头部字段,在爬虫中往往被网站用来判断请求的合法性。为了提高匿名性,可以使用随机的User-Agent,例如通过使用开源的User-Agent池来获取随机的User-Agent值,使爬虫的User-Agent变得多样化,难以被网站识别出来。其次,IP地址是另一个被用来判断爬虫的重要因素,为了隐藏真实的IP地址,可以使用代理服务器,通过多个代理IP进行请求,使得爬虫的请求看起来来自不同的IP地址,增加了隐匿性。此外,合理控制请求频率也是很重要的,过于频繁的请求容易被网站封禁IP或识别为爬虫,可以通过设置请求间隔时间或使用随机的请求频率来减少被发现的风险。

浏览器特征信息的修改

除了爬虫特征信息外,浏览器特征信息也是被用来判断爬虫的重要依据。其中,浏览器指纹是由浏览器的配置、插件和其他属性组成的唯一标识符,可以通过JavaScript代码获取。为了修改浏览器指纹,可以使用浏览器指纹混淆技术来模拟真实用户的浏览器指纹,例如添加随机的插件列表、修改浏览器配置等。此外,Canvas指纹也是一种常用的浏览器特征信息,它是通过浏览器绘制Canvas元素的API生成的唯一标识符。为了减少被识别风险,可以使用Canvas指纹混淆技术,通过修改Canvas元素的特征参数,如字体、字号、颜色等,使得每次请求生成的Canvas指纹都不同,增加了匿名性。

总结与建议

本文详细阐述了优化爬虫隐匿性的方法,主要集中在爬虫和浏览器特征信息的修改上。针对爬虫特征信息,可以采取随机User-Agent、代理服务器和请求限制等措施来提高匿名性。而对于浏览器特征信息,可以使用浏览器指纹混淆和Canvas指纹混淆等技术来减少爬虫的被识别风险。

在实际应用中,为了更加方便地实现爬虫隐匿性,建议使用穿云API。

使用穿云API,您可以轻松地绕过Cloudflare反爬虫的机器人验证,即使您需要发送10万个请求,也不必担心被识别为抓取者。

一个穿云API即可突破所有反Anti-bot机器人检查,轻松绕过Cloudflare、CAPTCHA验证,WAF,CC防护,并提供了HTTP API和Proxy,包括接口地址、请求参数、返回处理;以及设置Referer,浏览器UA和headless状态等各浏览器指纹设备特征。